Diese breite Akzeptanz durch Mitarbeiter und Organisationen hat zu neuen Cyber-, Technologie- und Betriebsrisiken geführt. Dazu gehören das Potenzial für Social Engineering, Sicherheitslücken und Systemausfälle. Um diese Risiken richtig einschätzen und bewältigen zu können, müssen Sie herausfinden, welche KI-Technologie Sie sich ansehen werden.

Künstliche Intelligenz ist keine einzige, einheitliche Technologie, sondern eine breite Kategorie, die viele verschiedene Anwendungen und Techniken umfasst. Um KI-Risiken zu verstehen, ist es wichtig, unsere Begriffe klar zu definieren, bevor das KI-Risiko analysiert wird.

Was ist KI?

Die erste Frage, die uns in Bezug auf KI-Risiken oft gestellt wird, lautet: „Was meinst du mit KI?“. KI, wie sie in den Medien und allgemein verwendet wird, ist ein Überbegriff für viele Arten von Anwendungen und Systemen der künstlichen Intelligenz. Diese werden oft von Menschen mit unterschiedlichen Auffassungen oder Anwendungsfällen miteinander vermischt. Dies kann zu Verwirrung darüber führen, welchen Risiken sie tatsächlich ausgesetzt sind, da die potenziellen Bedrohungen nicht dieselben sind.

Also habe ich beschlossen, einige der gängigsten KI-Chatbots zu fragen:

“Beschreiben Sie in einem Absatz, was KI ist und welche Arten von KI auf der Grundlage der am häufigsten verwendeten Fähigkeiten existieren?“

Chat GPT

Künstliche Intelligenz (KI) ist das Gebiet der Informatik, das es Maschinen ermöglicht, menschliche Intelligenz nachzuahmen, einschließlich Lernen, Denken und Problemlösen. Basierend auf ihren Fähigkeiten wird KI in drei Typen eingeteilt: Eingeschränkte KI, Allgemeine KI und Super-KI. Eingeschränkte KI (schwache KI) wurde für bestimmte Aufgaben wie virtuelle Assistenten, Gesichtserkennungs- und Empfehlungssysteme entwickelt. Allgemeine KI (Starke KI) bezieht sich auf Maschinen mit menschenähnlicher Intelligenz, die jede intellektuelle Aufgabe ausführen können, die ein Mensch kann, obwohl dies theoretisch bleibt. Super-KI übertrifft die menschliche Intelligenz und zeichnet sich durch fortgeschrittene Entscheidungsfindung, Kreativität und Selbstbewusstsein aus, aber sie ist rein hypothetisch. Diese Kategorien helfen dabei, die aktuellen Anwendungen und zukünftigen Möglichkeiten der KI zu definieren.

Microsoft Copilot

Künstliche Intelligenz (KI) bezieht sich auf die Entwicklung von Computersystemen, die Aufgaben ausführen können, die typischerweise menschliche Intelligenz erfordern, wie visuelle Wahrnehmung, Spracherkennung, Entscheidungsfindung und Sprachübersetzung. Basierend auf ihren Fähigkeiten kann KI in drei Haupttypen eingeteilt werden: Eingeschränkte KI, die für bestimmte Aufgaben wie virtuelle Assistenten (z. B. Siri, Alexa) konzipiert ist; allgemeine KI, die darauf abzielt, jede intellektuelle Aufgabe zu erledigen, die ein Mensch erledigen kann, obwohl sie zu diesem Zeitpunkt noch weitgehend theoretisch ist; und Superintelligente KI, die menschliche Intelligenz und Fähigkeiten übertrifft, ebenfalls ein theoretisches Konzept.

Claude

Künstliche Intelligenz (KI) bezieht sich auf Computersysteme, die für die Ausführung von Aufgaben konzipiert sind, die typischerweise menschliche Intelligenz erfordern. Sie umfasst sowohl enge KI (für bestimmte Aufgaben konzipiert) als auch allgemeine KI (hypothetisch in der Lage, menschenähnliche allgemeine Intelligenz zu entwickeln). Zu den gängigsten Typen, die auf Fähigkeiten basieren, gehören maschinelle Lernsysteme, die aus Datenmustern lernen, Deep-Learning-Modelle, die neuronale Netze zur komplexen Mustererkennung verwenden, natürliche Sprachverarbeitungssysteme zum Verstehen und Generieren menschlicher Sprache, Computer-Vision-Systeme zur Verarbeitung und Analyse visueller Informationen, Expertensysteme, die Entscheidungen auf der Grundlage vordefinierter Regeln treffen, Robotik-KI für die Automatisierung physischer Aufgaben und Reinforcement-Learning-Systeme, die durch Versuch und Irrtum lernen, um Entscheidungsprozesse zu optimieren. Während sich die engmaschige KI in bestimmten Bereichen wie Bilderkennung, Sprachübersetzung oder Spielen von Spielen auszeichnet, bleibt künstliche allgemeine Intelligenz (AGI), die in allen Bereichen der menschlichen Wahrnehmung entspricht oder diese übertrifft, ein theoretisches Ziel.

Zwillinge

Die obigen Antworten sind im Großen und Ganzen ähnlich. Die am häufigsten verwendete Art von KI-Technologie fällt unter engmaschige KI, manchmal auch als schwache KI bezeichnet. Dazu gehören:

- Große Sprachmodelle (LLMs)

- Generative KI (GenAI)

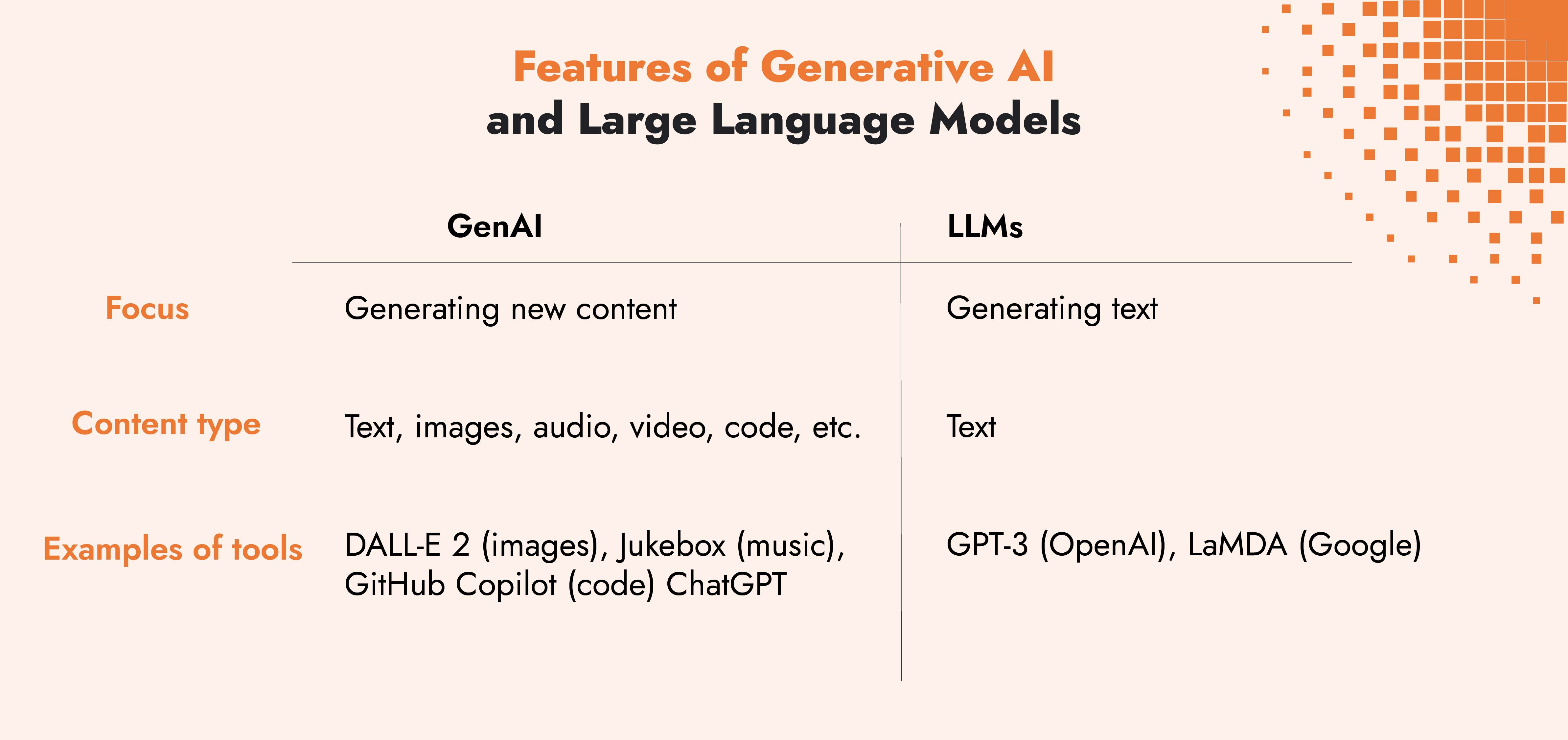

Der Unterschied zwischen LLMs und GenAI ist ihre Anwendung. LLMs sind eine Untergruppe der generativen KI und LLMs generieren nur Text. GenAI-Anwendungen können verschiedene Arten von Eingaben verwenden, z. B. Bilder oder Töne sowie Wörter, und die Anwendungen können Inhalte generieren, die Text, Bilder und Töne enthalten. Anwendungen wie ChatGPT, Microsoft Copilot oder Claude von Anthropic werden jetzt multimodales GENAI genannt, weil sie mehr als nur Text verarbeiten und generieren können.

Sobald Sie die Arten von KI identifiziert haben, die Sie oder Ihre Drittanbieter verwenden und bewerten müssen, können Sie die potenziellen Risikoszenarien, denen Sie und Ihr Unternehmen ausgesetzt sein könnten, besser einschätzen.

Die CIA-Triade und gemeinsame Risiken im Zusammenhang mit KI

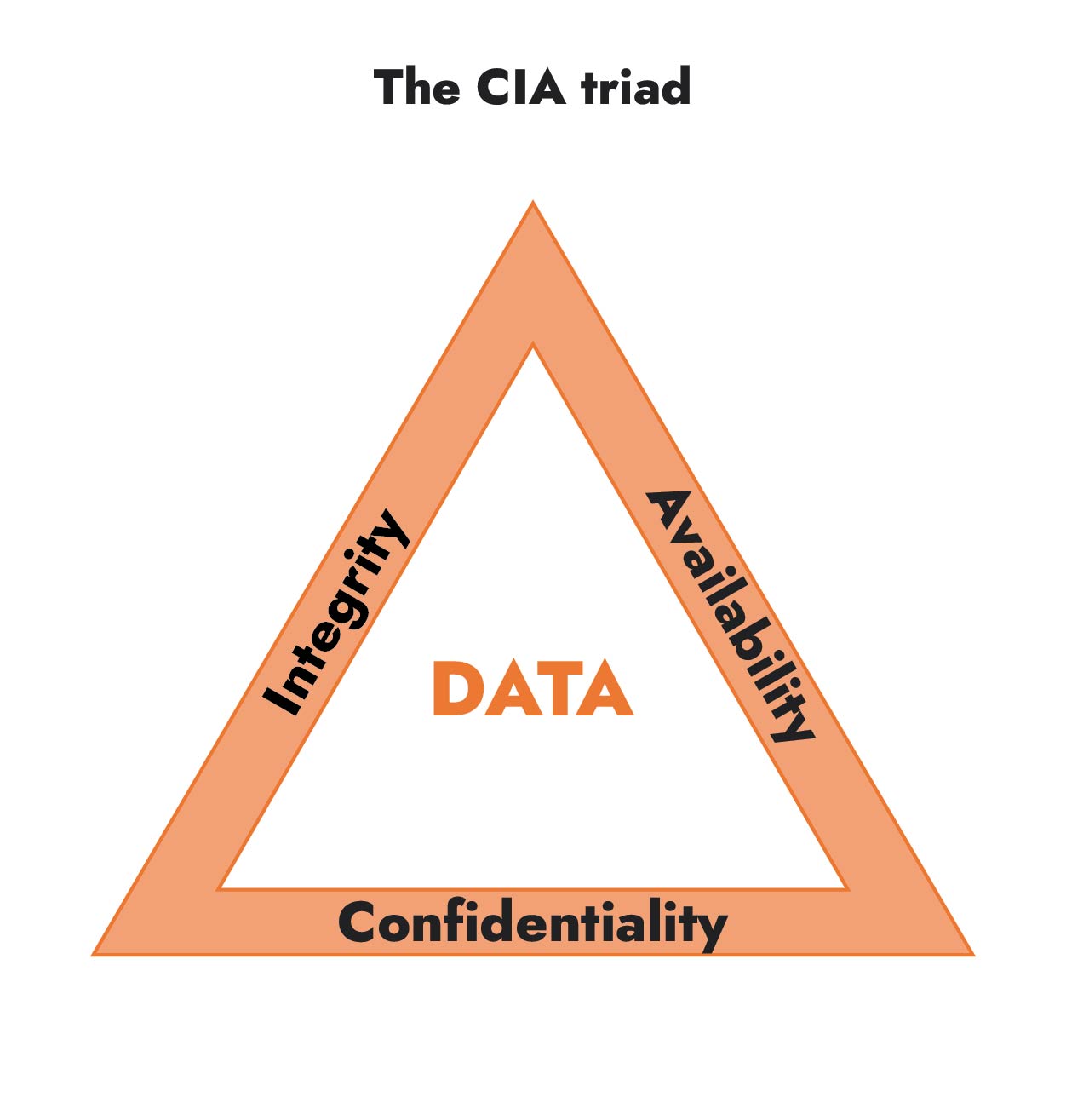

Für Risikomanager und politische Entscheidungsträger ist die CIA-Triade nützlich, um allgemeine KI-bezogene Risiken zu identifizieren.

Vertraulichkeit

- Mitarbeiter, die Open-Source-LLMs verwenden und vertrauliche Unternehmensinformationen preisgeben

- LLM von Drittanbietern verfügt über schlechte Kontrollen, was dazu führt, dass Ihre Daten per Prompt-Injection durchgesickert werden

- Cyberkriminelle nutzen KI-Tools, um Angriffe wie Phishing, die zu einer Sicherheitsverletzung führen, zu verstärken

Integrität

- Datenvergiftung durch LLM, was zu Problemen mit den Modellausgaben führt

- Die verwendeten Trainingsdaten werden nicht ordnungsgemäß gesichert oder verwaltet, was zu potenziellen Verzerrungen bei den Ergebnissen führen kann.

Verfügbarkeit

- Cyberkriminelle nutzen LLMs, um Zero-Day-Schwachstellen zu entdecken und auszunutzen

- Die Verwendung von LLMs für bestimmte Anwendungsfälle und wenn sie nicht verfügbar sind, führt dies zu Systemausfällen

Wie analysieren wir das KI-Risiko?

Um bei der Identifizierung der relevantesten KI-Risikoszenarien zu helfen, empfehlen wir, die in der Leitfaden für den FAIR-AIR-Ansatz. Dieser Ansatz hilft Risikoanalysten und Risikomanagern, dieselbe Sprache wie das Unternehmen zu sprechen, sodass Entscheidungsträger und Führungskräfte das Risiko verstehen und wissen, was zu tun ist, um das Risiko zu reduzieren.

5 Schritte zur Risikoanalyse mit dem FAIR-AIR-Ansatz

1) Kontextualisieren

- Warum analysieren Sie dieses Risiko und was ist der Grund dafür?

- Was sind Vektoren für KI-Risiken?

2) Geltungsbereich

- Identifizieren Sie Risikoszenarien

- Identifizieren Sie die Angriffsfläche, den Bedrohungsakteur, die Angriffsmethode und die Auswirkungen der Bedrohung auf Ihre Anlage

3) Quantifizieren

- Ermitteln Sie die Wahrscheinlichkeit und die Auswirkungen des Risikos

4) Priorisieren/Behandeln

- Bestimmen Sie die Behandlungsoptionen und priorisieren Sie diejenigen mit der größten Wirkung

5) Entscheidungsfindung

- Anhand der Ergebnisse und Behandlungsoptionen entscheiden Sie über den weiteren Plan

Stellen Sie die Risikoresistenz der KI mit fachkundiger Anleitung sicher

Vereinbaren Sie ein Gespräch mit einem unserer Experten für Cyber- und Technologierisiken, um mehr darüber zu erfahren, wie wir offene Standards und Frameworks integrieren, um Ihre KI-Risiken zu erfassen, zu bewerten und zu verwalten.

Beispiel für eine KI-Risikoanalyse mit FAIR-AIR

Welches Risiko besteht, wenn Mitarbeiter Open-Source-KI-Tools verwenden, um Berichte zu erstellen, indem sie sensible Kundendaten hochladen?

Indem Sie die von FAIR-AIR beschriebenen Schritte befolgen, können Sie ein datengestütztes Risikobild erstellen, um das potenzielle Risiko besser zu verstehen und zu entscheiden, wie es behandelt werden soll.

Wir werden das Beispiel einer Marketingagentur mit einem Umsatz von 200 Millionen Euro pro Jahr verwenden, die Kunden auf der ganzen Welt hat.

* Bitte beachten Sie, dass alle aufgeführten Zahlen und Daten nur zur Veranschaulichung dienen.

1) Kontextualisieren

Wir betrachten dieses Szenario, da sich das Unternehmen Sorgen darüber macht, dass Benutzer sensible Daten hochladen, und dass keine Kontrollen vorhanden sind, um dies zu verhindern. Sie erwägen, den Zugriff auf nicht zugelassene Tools zu blockieren.

2) Geltungsbereich

- Vermögenswert: Sensible Kunden- und Unternehmensdaten

- Bedrohungsakteur: Cyberkriminelle

- Angriffsfläche: Anzahl der Mitarbeiter mit Zugriff auf die sensiblen Daten

- Methode des Angriffs: Inversionsangriff modellieren

- Auswirkung: Rufschädigung, die zum Verlust bestehender und potenzieller Kunden sowie zu möglichen Bußgeldern von Kunden und Aufsichtsbehörden führt

3) Quantifizieren

- Wahrscheinlichkeit: Untersuchungen zum Einsatz von Tools im Unternehmen, zu Bedrohungsinformationen und externen Datenpunkten haben ergeben, dass die Wahrscheinlichkeit einer Datenschutzverletzung, die darauf zurückzuführen ist, dass Mitarbeiter sensible Kundendaten hochladen, 1-7%, wahrscheinlich 3%,

- Auswirkung: Auf Verluste in Höhe von rund 5 Mio. € geschätzt

4) Priorisieren/Behandeln

Der Hauptrisikofaktor ist der Zugriff auf sensible Kundendaten. Zu den Optionen gehören daher:

- Variante 1: Sperren Sie den Zugriff auf KI-Tools, sofern keine Ausnahme genehmigt wird (kostet 100.000€)

- Variante 2: Verbessern Sie die Benutzerzugriffskontrollen, um die Anzahl der Benutzer mit Zugriff auf vertrauliche Daten zu reduzieren (Kosten 160.000€)

- Möglichkeit 3: Implementieren Sie beide Optionen, 1 und 2 (kostet 250.000€)

5) Entscheidungsfindung

- Es wird davon ausgegangen, dass beide Optionen die Wahrscheinlichkeit des Eintretens dieses Risikoszenarios mit gleicher Wahrscheinlichkeit verringern, aber die Verbesserung der Zugangskontrollen wird mit höheren Kosten verbunden sein. Die Sperrung des Zugangs zu KI-Tools hat jedoch nachweislich den negativen Nebeneffekt, dass die Kreativität der Mitarbeiter, die die Tools verwenden, verringert wird, was möglicherweise zu Umsatzeinbußen führt. In diesem Fall wurde vereinbart, dass die Kontrolle mit der besten Kapitalrendite (ROI) Option 2 ist.

KI ist zwar eine neue und sich schnell entwickelnde Technologie, aber wie Sie im obigen Beispiel sehen können, ähneln die Risiken denen anderer vorhandener Technologien, wenn sie mit FAIR-AIR aufgeschlüsselt werden. Mitarbeiter können sensible Kundendaten auf verschiedene Arten hochladen oder durchsickern lassen. Die Verwendung eines Open-Source-Tools wie beschrieben ist nur ein zusätzlicher Angriffsvektor, den es zu berücksichtigen gilt.

Das FAIR Institute veröffentlichte auf seinem Blog eine Reihe zur Analyse KI-Risikoszenarien, die sich mit häufigen Bedrohungen befassen. Diese zeigen, wie Sie einen Vorfall so einordnen können, dass Sie die Auswirkungen und die Wahrscheinlichkeit eines Bedrohungsereignisses mithilfe eines quantitativen Ansatzes messen können.

Möglichkeiten der datengestützten KI

Die Einführung von KI-Tools und -Systemen beschleunigt sich, und damit geht eine Mischung aus Chancen und Risiken einher. Ein strukturierter, datengesteuerter Ansatz hilft Unternehmen dabei, KI-Risiken zu bewerten, potenzielle Auswirkungen zu quantifizieren und Strategien zur Risikominderung zu priorisieren. Wie in unserem Beispiel zu sehen ist, sind KI-Risiken nicht völlig neu und können bestehenden Cybersicherheitsbedrohungen ähneln. Der Schlüssel liegt in der Anpassung der Risikomanagementstrategien an die einzigartigen Angriffsvektoren der KI.

Anstatt den Einsatz von KI einzuschränken, sollten Unternehmen einen risikobasierten Ansatz verfolgen und Kontrollen implementieren, die Risiken mindern und es den Mitarbeitern dennoch ermöglichen, die Vorteile der KI zu nutzen. Eine starke KI-Governance, klare Richtlinien und eine kontinuierliche Überwachung werden entscheidend sein, um eine verantwortungsvolle Einführung von KI in einer sich entwickelnden Bedrohungslandschaft sicherzustellen.

Lassen Sie nicht zu, dass unkontrollierte Risiken Ihre Innovation bremsen. C-Risk unterstützt Unternehmen dabei, bei der Einführung von KI einen datengesteuerten, risikobasierten Ansatz zu verfolgen, der Sicherheit, Compliance und Geschäftskontinuität gewährleistet. Vereinbaren Sie einen Anruf, um loszulegen!

Häufig gestellte Fragen zu KI und Risikoanalyse

Was ist ein großes Sprachmodell oder LLM?

Ein Large Language Model (LLM) ist ein neuronales Netzwerk, das auf riesigen Mengen von hauptsächlich von Menschen generierten Daten trainiert wird. LLMs werden mithilfe von Deep-Learning-Techniken erstellt und können Aufgaben zur Verarbeitung natürlicher Sprache wie das Beantworten von Fragen, die Generierung von Texten und das Zusammenfassen von Texten ausführen. Die beliebtesten LLMs, mit denen wir interagieren, sind GPTs oder Generative Pre-Trained Transformers wie ChatGPT von OpenAI, Microsoft Copilot und Gemini von Google.

Was ist FAIR-AIR?

FAIR-AIR ist ein KI-Ansatz zur Risikobewertung, der Risikoanalysten und Führungskräften helfen soll, KI-bezogene Risiken zu identifizieren und fundierte Entscheidungen zu deren Bewältigung zu treffen. Er wurde von der GenAI-Arbeitsgruppe des FAIR-Instituts entwickelt und basiert auf dem Open FAIR™ -Modell für die Risikoanalyse. FAIR-AIR wendet die Techniken des FAIR-Frameworks an, um KI-bezogene Risiken in probabilistischer und finanzieller Hinsicht zu modellieren und zu quantifizieren.

Wir entwickeln skalierbare Lösungen zur Quantifizierung von Cyberrisiken in finanzieller Hinsicht, damit Unternehmen fundierte Entscheidungen treffen können, um Unternehmensführung und Widerstandsfähigkeit zu verbessern.