Cette adoption généralisée par les employés et les organisations a introduit de nouveaux risques cyber, technologiques et opérationnels. Il s'agit notamment du potentiel d'ingénierie sociale, de failles de sécurité et de défaillances des systèmes. Pour évaluer et gérer correctement ces risques, vous devez identifier la technologie d'IA que vous allez examiner.

L'intelligence artificielle n'est pas une technologie unique et uniforme, mais une vaste catégorie englobant de nombreuses applications et techniques différentes. Pour commencer à comprendre les risques liés à l'IA, il est important de définir clairement nos termes avant d'analyser les risques liés à l'IA.

Qu'est-ce que l'IA ?

La première question que l'on nous pose souvent à propos des risques liés à l'IA est "Qu'entendez-vous par IA ?". L'IA, telle qu'elle est utilisée dans les médias et plus généralement, est un terme générique désignant de nombreux types d'applications et de systèmes d'intelligence artificielle. Ils sont souvent mélangés par des personnes ayant des compréhensions ou des cas d'utilisation différents en tête. Cela peut prêter à confusion quant aux risques réels auxquels ils sont confrontés, car les menaces potentielles ne sont pas les mêmes.

J'ai donc décidé de poser la question à certains des chatbots IA les plus courants :

« Dans un paragraphe, décrivez ce qu'est l'IA et quels en sont les différents types en fonction des capacités les plus couramment utilisées? »

Chat GPT

L'intelligence artificielle (IA) est le domaine de l'informatique qui permet aux machines d'imiter l'intelligence humaine, notamment en matière d'apprentissage, de raisonnement et de résolution de problèmes. Sur la base de ses capacités, l'IA est classée en trois types : IA étroite, IA générale et Super IA. L'IA étroite (IA faible) est conçue pour des tâches spécifiques, telles que les assistants virtuels, la reconnaissance faciale et les systèmes de recommandation. L'IA générale (IA forte) fait référence à des machines dotées d'une intelligence semblable à celle d'un humain qui peuvent effectuer toutes les tâches intellectuelles qu'un humain peut accomplir, même si cela reste théorique. La super IA surpasse l'intelligence humaine, faisant preuve de prise de décision avancée, de créativité et de conscience de soi, mais elle est purement hypothétique. Ces catégories permettent de définir les applications actuelles et les possibilités futures de l'IA.

Microsoft Copilot

L'intelligence artificielle (IA) fait référence au développement de systèmes informatiques capables d'effectuer des tâches nécessitant généralement l'intelligence humaine, telles que la perception visuelle, la reconnaissance vocale, la prise de décision et la traduction linguistique. Sur la base des capacités, l'IA peut être classée en trois types principaux : l'IA étroite, conçue pour des tâches spécifiques telles que les assistants virtuels (par exemple, Siri, Alexa) ; l'IA générale, qui vise à effectuer toutes les tâches intellectuelles qu'un humain peut accomplir, même si elle reste largement théorique à ce stade ; et l'IA super intelligente, qui surpasse l'intelligence et les capacités humaines, également un concept théorique.

Claude

L'intelligence artificielle (IA) fait référence aux systèmes informatiques conçus pour effectuer des tâches nécessitant généralement une intelligence humaine, englobant à la fois l'IA restreinte (conçue pour des tâches spécifiques) et l'IA générale (hypothétiquement capable d'une intelligence générale semblable à celle de l'homme). Les types les plus courants basés sur les capacités incluent les systèmes d'apprentissage automatique qui apprennent à partir de modèles de données, les modèles d'apprentissage en profondeur utilisant des réseaux neuronaux pour la reconnaissance de formes complexes, les systèmes de traitement du langage naturel pour générer et le langage humain, les systèmes de vision par ordinateur pour traiter et analyser les informations visuelles, les systèmes experts qui prennent des décisions en fonction de règles prédéfinies, l'IA robotique pour l'automatisation des tâches physiques et les systèmes d'apprentissage par renforcement qui apprennent par essais et erreurs pour optimiser les processus de prise de décision. Alors que l'IA restreinte excelle dans des domaines spécifiques tels que la reconnaissance d'images, la traduction linguistique ou les jeux vidéo, l'intelligence artificielle générale (AGI) qui correspond ou dépasse la cognition humaine dans tous les domaines reste un objectif théorique.

Gemini

L'intelligence artificielle (IA) est la capacité d'un ordinateur ou d'une machine à imiter l'intelligence humaine. Cela peut impliquer des choses comme l'apprentissage, la résolution de problèmes et la prise de décisions. L'IA est un vaste domaine, et il existe de nombreux types d'IA. Les types d'IA les plus courants sont l'IA étroite ou faible, l'IA générale ou l'IA forte et la super IA. L'IA étroite est conçue pour une tâche spécifique, comme jouer aux échecs ou recommander des produits. C'est le type d'IA le plus courant aujourd'hui. L'IA générale est un type d'IA théorique doté d'une intelligence de niveau humain, capable d'effectuer toutes les tâches intellectuelles qu'un humain peut accomplir. La super IA est également théorique et surpasserait l'intelligence humaine à tous égards. Alors que l'IA générale et la super intelligence relèvent encore largement du domaine de la science-fiction, l'IA restreinte a déjà un impact significatif sur notre monde.

Les réponses ci-dessus sont globalement similaires. Le type de technologie d'IA le plus couramment utilisé relève de l'IA restreinte, parfois appelée IA faible. Cela inclut :

- Modèles linguistiques étendus (LLM)

- IA générative (GenAI)

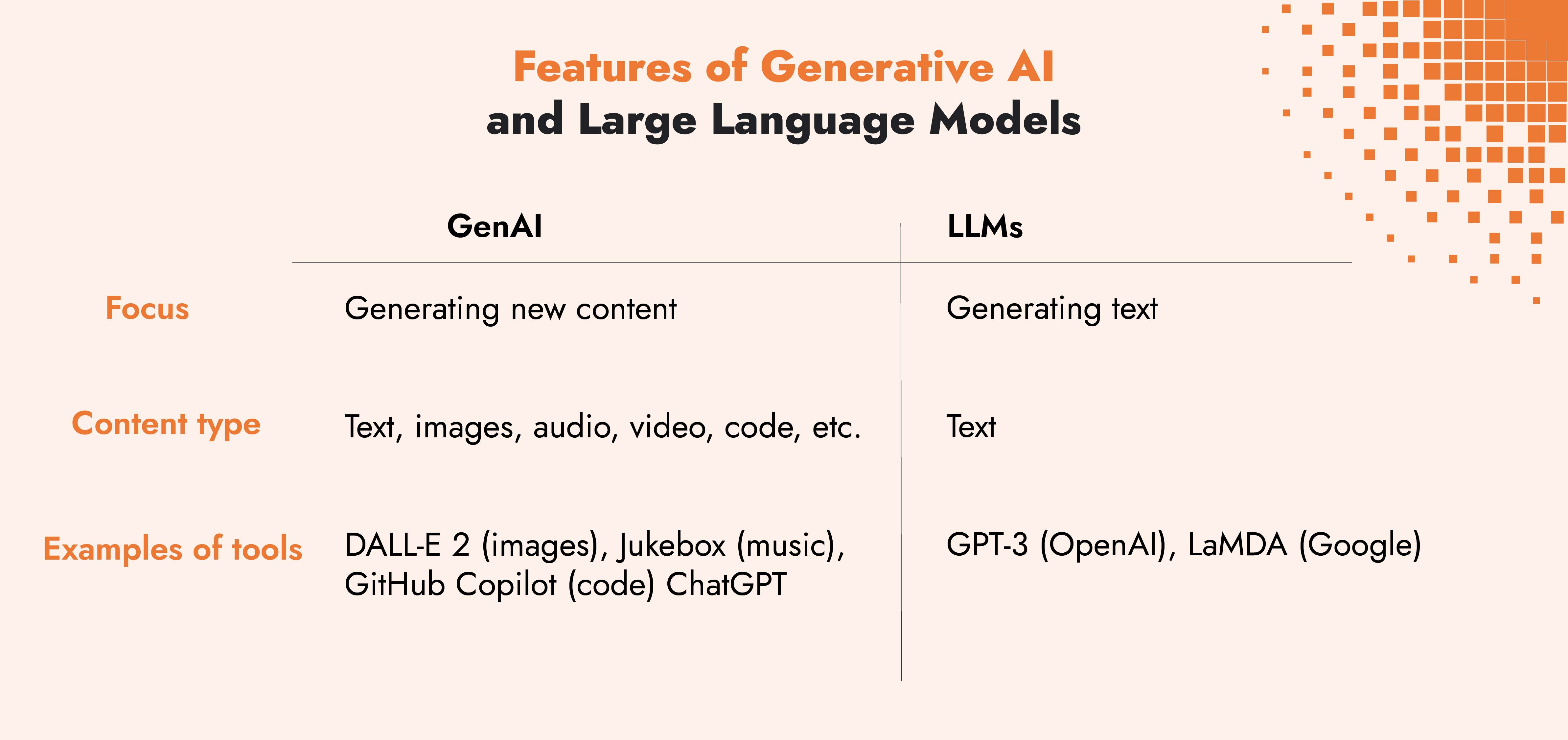

La différence entre les LLM et GenAI réside dans leur application. Les LLM sont un sous-ensemble de l'IA générative et les LLM ne génèrent que du texte. Les applications GenAI peuvent utiliser différents types d'entrées, telles que des images ou des sons ainsi que des mots, et les applications peuvent générer du contenu comprenant du texte, des images et des sons. Des applications telles que ChatGPT, Microsoft Copilot ou Anthropic's Claude sont désormais appelées GenAI multimodales car elles peuvent traiter et générer bien plus que du texte.

Une fois que vous aurez identifié les types d'IA que vous ou vos tiers utilisez et que vous devez évaluer, vous serez en mesure de mieux définir les scénarios de risques potentiels auxquels vous et votre entreprise pourriez être confrontés.

La triade de la CIA et les risques courants liés à l'IA

Pour les gestionnaires des risques et les décideurs politiques, la triade de la CIA (Confidentiality, Integrity, Availability en anglais) est utile pour identifier les risques courants liés à l'IA.

Confidentialité

- Employés utilisant des LLM open source et divulguant des informations sensibles sur l'entreprise

- Le LLM tiers dispose de contrôles médiocres, ce qui entraîne la fuite de vos données par injection rapide

- Les cybercriminels utilisent des outils d'IA pour renforcer les attaques, telles que le phishing, qui entraîne une violation

Intégrité

- L'empoisonnement des données du LLM entraîne des problèmes avec les sorties du modèle

- Les données de formation utilisées ne sont pas correctement sécurisées ou mises à jour, ce qui peut entraîner un biais dans leurs résultats

Disponibilité

- Les cybercriminels utilisent les LLM pour découvrir et exploiter les vulnérabilités Zero Day

- L'utilisation de LLM pour des cas d'utilisation spécifiques et, en cas d'indisponibilité, entraîne une panne du système

Comment analysons-nous les risques liés à l'IA ?

Pour vous aider à identifier les scénarios de risque liés à l'IA les plus pertinents, nous vous recommandons de suivre les étapes décrites dans le manuel d'approche FAIR-AIR. Cette approche aide les analystes des risques et les responsables des risques à parler le même langage que l'entreprise, afin que les décideurs et les dirigeants puissent comprendre le risque et les mesures à prendre pour le réduire.

5 étapes pour analyser les risques à l'aide de l'approche FAIR-AIR

1) Contextualiser

- Pourquoi analysez-vous ce risque et quelles en sont les raisons ?

- Quels sont les vecteurs du risque lié à l'IA ?

2) Champ d'application

- Identifier les scénarios de risque

- Identifier la surface d'attaque, l'acteur de la menace, la méthode d'attaque et l'impact de la menace sur votre actif

3) Quantifier

- Déterminer la probabilité et l'impact du risque

4) Prioriser/traiter

- Déterminer les options de traitement et prioriser celles qui ont le plus d'impact

5) Prise de décisions

- À l'aide des résultats et des options de traitement, décider du plan pour l'avenir

Assurez la résilience aux risques liés à l'IA grâce aux conseils d'experts

Planifiez un appel avec l'un de nos experts en risques informatiques et technologiques pour en savoir plus sur la manière dont nous intégrons des normes et des cadres ouverts pour définir, évaluer et gérer vos risques liés à l'IA.

Exemple d'analyse des risques liés à l'IA à l'aide de FAIR-AIR

Quel est le risque que les employés utilisent des outils d'IA open source pour générer des rapports en téléchargeant des données clients sensibles ?

En suivant les étapes décrites par FAIR-AIR, vous pouvez créer une image du risque basée sur des données afin de mieux comprendre le risque potentiel, afin de pouvoir décider comment le traiter.

Nous prendrons l'exemple d'une agence de marketing dont le chiffre d'affaires s'élève à 200 millions d'euros par an et qui compte des clients dans le monde entier.

* Veuillez noter que tous les chiffres et données répertoriés sont fournis à titre indicatif uniquement.

1) Contextualiser

Nous envisageons ce scénario car l'entreprise s'inquiète du fait que les utilisateurs téléchargent des données sensibles et de l'absence de contrôles pour empêcher cela. Ils envisagent de bloquer l'accès à des outils non approuvés.

2) Champ d'application

- Atout : Données sensibles relatives aux clients et à l'entreprise

- Acteur de la menace : Les cybercriminels

- Surface d'attaque : Nombre d'employés ayant accès aux données sensibles

- Méthode d'attaque : Attaque d'inversion de modèle

- Incidence : Atteinte à la réputation entraînant la perte de clients existants et potentiels, ainsi que des amendes potentielles de la part des clients et des régulateurs

3) Quantifier

- Probabilité : grâce à des recherches sur l'utilisation des outils dans l'entreprise, les renseignements sur les menaces et les points de données externes, il existe une probabilité de 1 à 7 %, très probablement 3 %, d'une violation de données due au téléchargement par les employés de données sensibles sur les clients

- Incidence : Des pertes estimées à environ 5 millions d'euros

4) Prioriser/traiter

Le principal facteur de risque étant l'accès aux données sensibles des clients, les options incluent :

- Option 1 : Bloquer l'accès aux outils d'IA à moins qu'une exception ne soit approuvée (coût 100 000€)

- Option 2 : Améliorer les contrôles d'accès des utilisateurs afin de réduire le nombre d'utilisateurs ayant accès à des données sensibles (coût 160 000€)

- Option 3 : Mettre en œuvre les deux options, 1 et 2 (coût 250 000€)

5) Prise de décisions

- Les deux options sont considérées comme étant également susceptibles de réduire la probabilité que ce scénario de risque se produise, mais l'amélioration des contrôles d'accès aura un coût plus élevé. Il est toutefois établi que le blocage de l'accès aux outils d'IA a pour effet secondaire négatif de réduire la créativité du personnel qui les utilise, ce qui peut entraîner une perte de revenus. Dans ce cas, il est convenu que le contrôle offrant le meilleur retour sur investissement (ROI) est l'option 2.

Bien que l'IA soit une technologie nouvelle qui évolue rapidement, comme vous pouvez le voir dans l'exemple ci-dessus, les risques sont similaires à ceux des autres technologies existantes lorsqu'elle est analysée à l'aide de FAIR-AIR. Les employés peuvent télécharger ou divulguer des données clients sensibles de plusieurs manières et l'utilisation d'un outil open source tel que décrit n'est qu'un vecteur d'attaque supplémentaire à prendre en compte.

Le FAIR Institute a publié une série sur son blog analysant Scénarios de risque liés à l'IA qui répondent aux menaces courantes. Ils montrent comment définir un incident afin de pouvoir mesurer l'impact et la probabilité d'une menace à l'aide d'une approche quantitative.

Opportunités d'IA fondées sur les données

L'adoption d'outils et de systèmes d'IA s'accélère, ce qui entraîne un mélange d'opportunités et de risques. Une approche structurée et axée sur les données aide les organisations à évaluer les risques liés à l'IA, à quantifier l'impact potentiel et à hiérarchiser les stratégies d'atténuation. Comme le montre notre exemple, les risques liés à l'IA ne sont pas entièrement nouveaux et peuvent ressembler à des menaces de cybersécurité existantes. La clé est d'adapter les stratégies de gestion des risques pour faire face aux vecteurs d'attaque uniques de l'IA.

Plutôt que de restreindre l'utilisation de l'IA, les organisations devraient adopter une approche basée sur les risques, en mettant en œuvre des contrôles qui atténuent les risques tout en permettant aux employés de tirer parti des avantages de l'IA. Une gouvernance solide en matière d'IA, des politiques claires et une surveillance continue seront cruciales pour garantir une adoption responsable de l'IA dans un paysage de menaces en évolution.

Ne laissez pas les risques non gérés ralentir votre innovation. C-Risk aide les organisations à adopter une approche basée sur les données et les risques pour adopter l'IA, en garantissant la sécurité, la conformité et la continuité des activités. Planifiez un appel pour commencer !

FAQ sur l'IA et l'analyse des risques

Qu'est-ce qu'un grand modèle linguistique ou LLM ?

Un grand modèle de langage (LLM) est un réseau neuronal entraîné à partir d'énormes quantités de données, principalement générées par l'homme. Les LLM sont conçus à l'aide de techniques d'apprentissage en profondeur et peuvent effectuer des tâches de traitement du langage naturel telles que la réponse à des questions, la génération de texte et la synthèse. Les LLM les plus populaires avec lesquels nous interagissons sont les GPT ou Generative Pre-trained Transformers, tels que ChatGPT d'OpenAI, Microsoft Copilot et Gemini de Google.

Qu'est-ce que FAIR-AIR ?

FAIR-AIR est une approche d'évaluation des risques liés à l'IA conçue pour aider les analystes des risques et les dirigeants à identifier les risques liés à l'IA et à prendre des décisions éclairées sur la manière de les gérer. Développé par le groupe de travail GenAI du FAIR Institute, il est basé sur le modèle Open FAIR™ pour l'analyse des risques. FAIR-AIR applique les techniques du cadre FAIR pour modéliser et quantifier les risques liés à l'IA en termes probabilistes et financiers.

Nous avons conçu des solutions évolutives pour quantifier les risques cyber en termes financiers afin que les organisations améliorent leur gouvernance et leur résilience grâce à des décisions éclairées.